C. QUI A PEUR DE LA FRAUDE SOCIALE ?

Par rapport aux administrations de Bercy, dont les moyens sont limités mais qui font preuve de volontarisme, les organismes de sécurité sociale apparaissent nettement sur la défensive. Il existe bien un recours au datamining dans le cadre de la lutte contre la fraude, mais celui-ci est à la fois plus récent, moins généralisé, et moins assumé.

Surtout, d'après les informations disponibles, celui-ci ne s'appuie pas sur l'IA, sauf à définir celle-ci comme le simple recours à des méthodes statistiques, mais en tout état de cause pas sur du machine learning complexe, et encore moins sur du deep learning ou de l'IA générative. Ainsi, l'algorithme utilisé par la CAF, objet d'une polémique en 2023, n'est qu'un « simple » croisement de données sur la base d'un modèle statistique.

L'algorithme « datamining données entrantes » (DMDE) de la CAF

Depuis 2011, la CAF utilise un algorithme de datamining pour orienter la programmation de ses contrôles parmi les quelque 13,8 millions de foyers d'allocataires. Les contrôles eux-mêmes sont effectués sur place (à domicile) par 700 contrôleurs assermentés, et aucune décision n'est prise sur la base d'un traitement automatisé, conformément au cadre posé par la loi et la Cnil.

L'algorithme, conçu par des statisticiens, calcule un « score de risque » (de 0 à 1) à partir d'une quarantaine de critères (sur les 300 informations que contient un dossier) correspondant aux facteurs de risque constatés sur les contrôles passés ayant révélé des irrégularités. Ce traitement a été autorisé par la Cnil.

Seules les données internes de la CAF sont utilisées : résidence en France, situation familiale (couple, parent isolé, etc.), professionnelle (en activité, demandeur d'emploi, etc.) et financière (revenus imposables et non imposables). Les informations ne sont pas croisées avec les données provenant d'autres organismes (Pôle Emploi notamment).

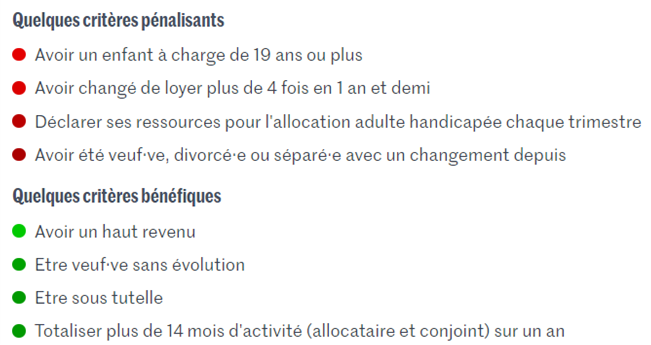

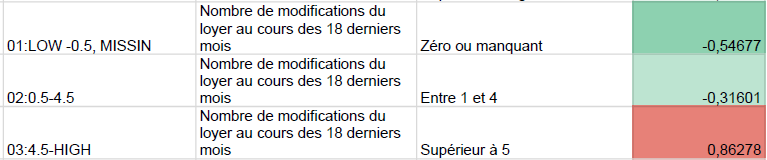

Exemples de critères utilisés par l'algorithme

Le Monde, « Profilage et discriminations : enquête sur les dérives de l'algorithme des CAF », 12 avril 2023, d'après les données communiquées par la Cnaf (code source, liste des variables et coefficients pour les algorithmes 2010-2014 et 2014-2020) et analysées par Lighthouse Reports

En 2021, 70 % des contrôles sur place étaient issus du datamining, mais seulement 1 % du total des contrôles de la CAF (ceux-ci se font principalement sur pièces, et sans datamining).

L'algorithme a été accusé de « discriminer les plus vulnérables », notamment par des associations comme La Quadrature du Net ou ATD Quart Monde. Dans la mesure où les aides versées par la CAF (RSA, prime d'activité, aides au logement, AAH, etc.) sont par définition destinées à un public plus vulnérable, le reproche est difficile à entendre, sauf à considérer qu'il est plus « juste » de contrôler complètement au hasard et d'ignorer les modèles statistiques. Toutefois, il est vrai que si les 40 critères sont fondés sur des calculs statistiques, la décision de les inclure ou non dans l'algorithme reste discrétionnaire. Avec l'apprentissage automatique non supervisé, ce problème n'existerait pas, puisqu'on ne donne aucun critère a priori à la machine : c'est elle qui les « découvre » elle-même. En un sens, c'est plus objectif.

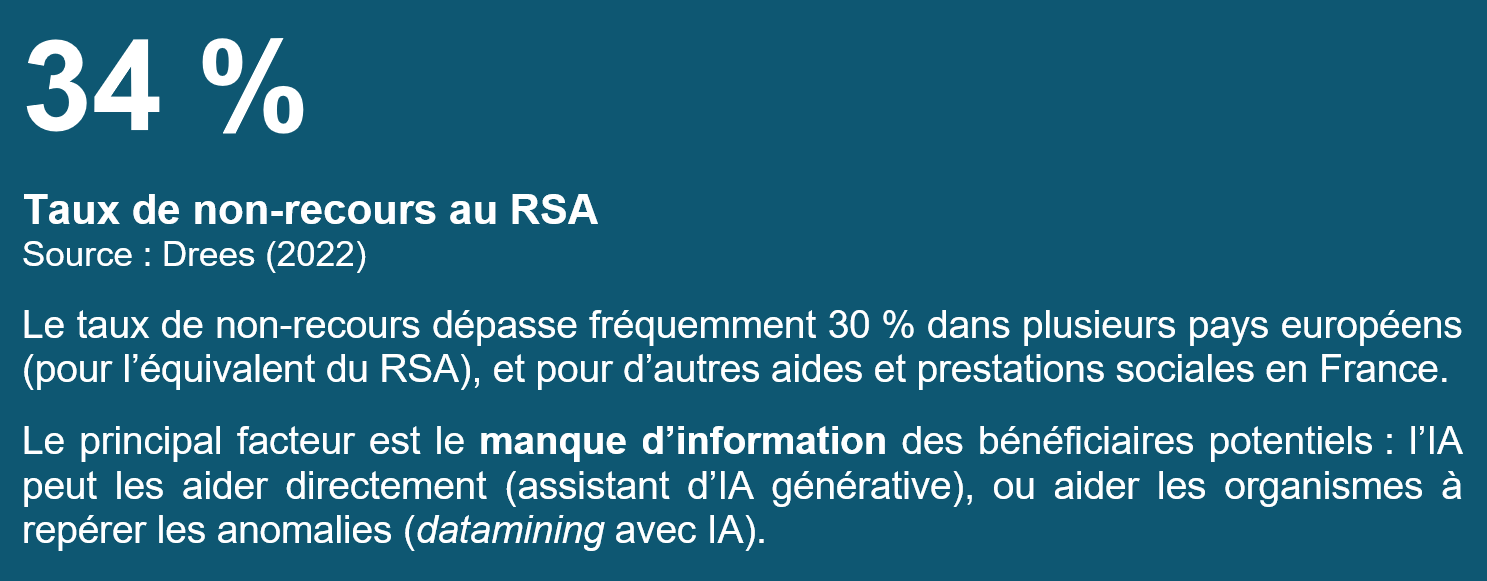

On a aussi reproché à l'algorithme d'avoir pour seul objectif la lutte contre la fraude, ce que la CAF dément. Cet objectif de lutte contre la fraude doit pourtant être assumé, car il est une condition de la justice et de l'efficacité de notre système de redistribution. Il n'est cependant pas le seul objectif : l'algorithme vise à détecter des anomalies et pas à les caractériser, celles-ci pouvant également correspondre à des erreurs de bonne foi, à des erreurs internes, ou à des situations de non-recours. D'ailleurs, si les contrôles sur place issus du datamining donnent lieu à une réclamation de trop-perçu dans 50 % des cas (contre 1 % pour les contrôles en général), ils donnent aussi lieu à un versement en faveur des allocataires dans 27 % des cas, au titre de prestations dues mais non versées ou non réclamées.

De fait, c'est bien la même technologie qui permet de lutter contre la fraude et lutter contre le non-recours, et ne pas l'utiliser, c'est ne remplir aucun des deux objectifs.

En tout état de cause, la marge d'amélioration est importante : en 2023, la Cour des comptes a ainsi refusé de certifier les comptes de la Cnaf, la somme des « erreurs » (versements « indus » et « non versés à tort ») atteignant 5,8 milliards d'euros soit 7,6 % du montant total des prestations.

Les résultats de la lutte contre la fraude sociale viennent toutefois de connaître une amélioration très nette, comme l'a indiqué le Premier ministre (cf. supra). Les redressements notifiés par l'Urssaf, par exemple, ont augmenté de 50 %, à 1,2 milliard d'euros, et le montant des fraudes détectées par l'Assurance maladie de 50 % également, 466 millions d'euros. La même tendance est constatée pour l'Assurance vieillesse et la CAF.

S'il faut évidemment se féliciter de ces résultats, de tels écarts laissent tout de même songeur : soit c'est la fraude elle-même qui a subitement augmenté, dans tous les domaines en même temps, ce qui est peu vraisemblable, soit cette hausse spectaculaire est le signe que la lutte contre la fraude était très largement déficiente - et qu'il demeure sans doute d'importantes marges de progression.

En effet, ces résultats ont principalement été obtenus par un datamining « basique », avec de simples croisements de données, soit une technologie déjà disponible et maîtrisée en interne depuis une dizaine d'années, sans IA, et avec peu ou pas de croisements de données entre organismes ou administrations. Le Premier ministre a donc eu raison de relever les objectifs fixés en matière de lutte contre la fraude sociale.

Le recours au datamining et à l'IA dans la lutte contre la fraude n'est pas une solution miracle, et il pose évidemment des problèmes spécifiques. En revanche, il n'y a pas de raison que les enjeux soient différents dans la sphère fiscale et dans la sphère sociale. Il semble donc que le « retard » constaté depuis des années dans la sphère sociale tienne davantage à une moindre « culture » de la lutte contre la fraude, et cela n'est pas justifiable : « frauder, c'est voler », pour reprendre les mots du Premier ministre, et toutes les sommes ainsi perdues rendent notre système social à la fois moins efficace, moins équitable et moins généreux.